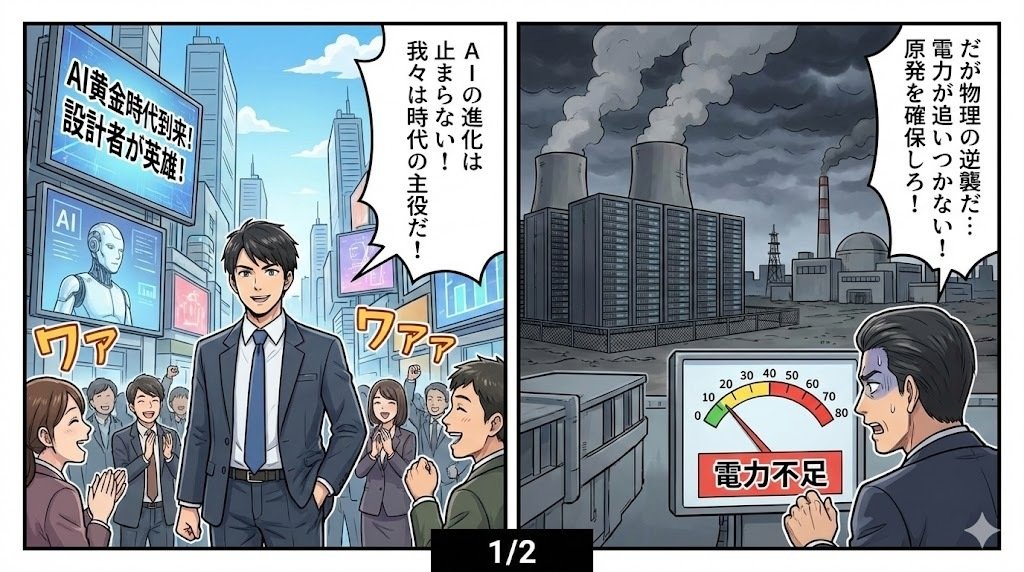

2026年、AI設計者が時代の主役と称えられ、世界はAIの進化に熱狂していた。

しかし、その裏側では意外にも冷徹な限界が顔を見せ始めていた。

深層学習、クラウド、ビッグデータ——この三位一体の力でAI冬の時代を救ってきたはずだった。

だが今、計算資源やデータの壁が次々と立ちはだかっている。

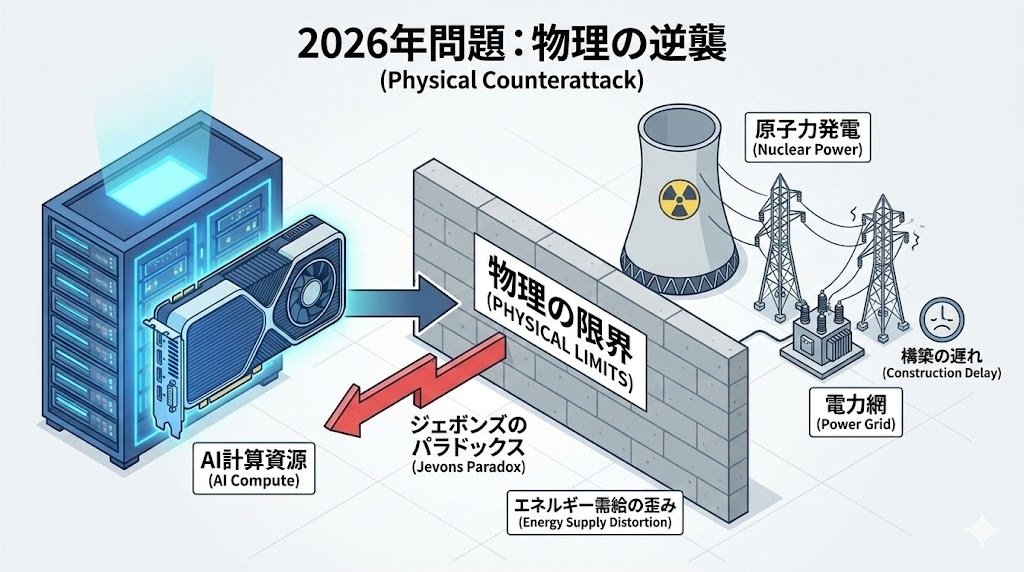

現状、AIを動かすための効率は確かに向上し続けているものの、資源消費量も増え、まさに「ジェボンズのパラドックス」が現実となっている。

GPUの性能向上で機械学習環境は飛躍的に普及したが、その分だけ電力需要が急増しているのだ。

大手テック企業が自ら原子力発電所を確保し始め、エネルギー需給のバランス自体が歪むようになった。

有形資産として膨大な電力網やデータセンターを構築する必要が出てきており、ソフトウェアが即時性を持って進化しても、物理的な世界の制約がそのスピードに追いつかない。

「物理の逆襲」が始まりつつあるのを肌で感じる。

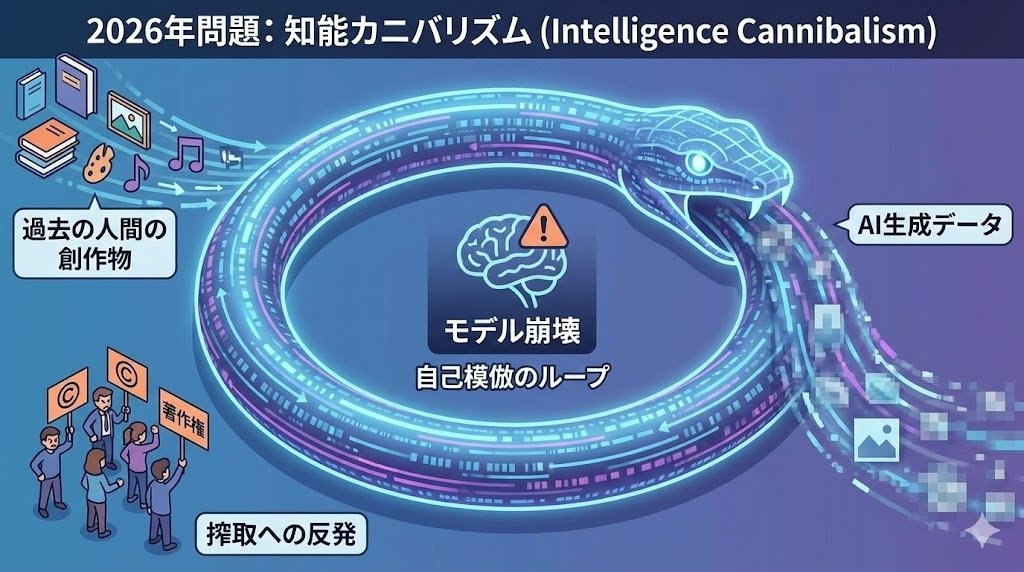

さらに深刻なのが、AIの性能を支えるデータ自体の枯渇だ。

AIはインターネット上にある膨大な人間の創作物を飲み込み続けてきたが、2026年には「高品質なエサ」が底を尽き始めている。

新たな懸念は、AIが自分で生成したデータを自分で学習し、出力が画一化・劣化していく「モデル崩壊」現象だ。

SNS上でも、AIが「過去情報の巨大オウム」と揶揄される声が止まない。

創造性がループに陥り自己模倣を繰り返すリスクがいよいよ現実味を帯びてきている。

人々の感情も一筋縄ではいかない。

半導体メーカーやテック企業に富が集中し続ける一方で、消費者はAIの消費電力増大に伴うコスト負担を感じ始めている。

自分の著作権が「学習」という名の下で搾取されていることへの憤りも強まっている。

一方で、「囲い込み運動」によりかつて共有されていた知識や文化資産が急速に私有化され、テック大手の独占が進行していることへの反発も起きている。

企業のAI導入が利益追求に拍車をかける中、実力以上の期待を抱いてしまいがちな「ダニング=クルーガー効果」的な過信も目立つ。

投資バブル崩壊への不安も高まっている。

皮肉なことに、AIが賢くなりすぎたせいで学習対象そのものを食い尽くし、動作エネルギーの確保にも限界が来ている――まさに「知能カニバリズム」と呼ぶべき状況だろう。

これを打破するには、単純にモデルを巨大化させるだけでは通用せず、全く新しいパラダイムへの転換が求められている。

歴史を振り返ると、こうした技術ブームの後には必ず現実が襲いかかる。

AIという「魔法の杖」も、重厚な物理インフラと倫理的な合意の上でしか成立しない。

そして、そのためには極めて高いコストが必要だという現実を、改めて痛感している。

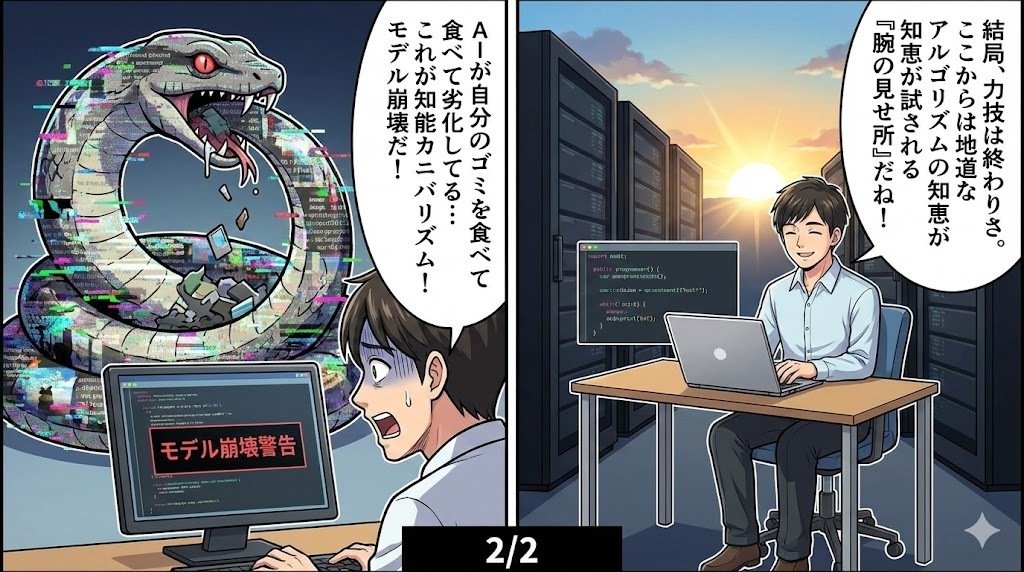

プログラマーとしては「スケーリング・ロー(規模の法則)」の限界が、ついに物理レイヤーにまで到達したという感覚を強く持った。

これまで私たちは、コードの最適化よりも「より速いマシン、より多くのデータ」を投入することで、力技で問題を解決してきた。

しかし、「2026年問題」は、そのブルートフォース(総当たり)的なアプローチが、ついに地球の資源とインターネットのデータ総量というハードリミットにぶつかったことを示唆している。

特に「モデル崩壊」は、プログラミングにおける「ガベージイン・ガベージアウト(ゴミを入れたらゴミが出てくる)」の最悪の形態です。

再帰的な学習が不純物を濃縮し、システムの不確実性を増大させる様子は、デバッグ不可能な巨大なスパゲッティコードを見ているような恐怖を感じる。

今後は「いかに増やすか」ではなく、限られた計算資源と純粋なデータの中で「いかに効率よく賢くするか」という、アルゴリズム本来の知恵が試される、ある意味でプログラマーにとって「腕の見せ所」の時代に戻るのではないかと、期待と不安が入り混じった感想を抱いた。