生成AIの普及によって、便利な要約やチャットによる検索サービスが日常に溶け込む一方、AIの仕組みを悪用した新たなネット詐欺の手口が次々と誕生している。

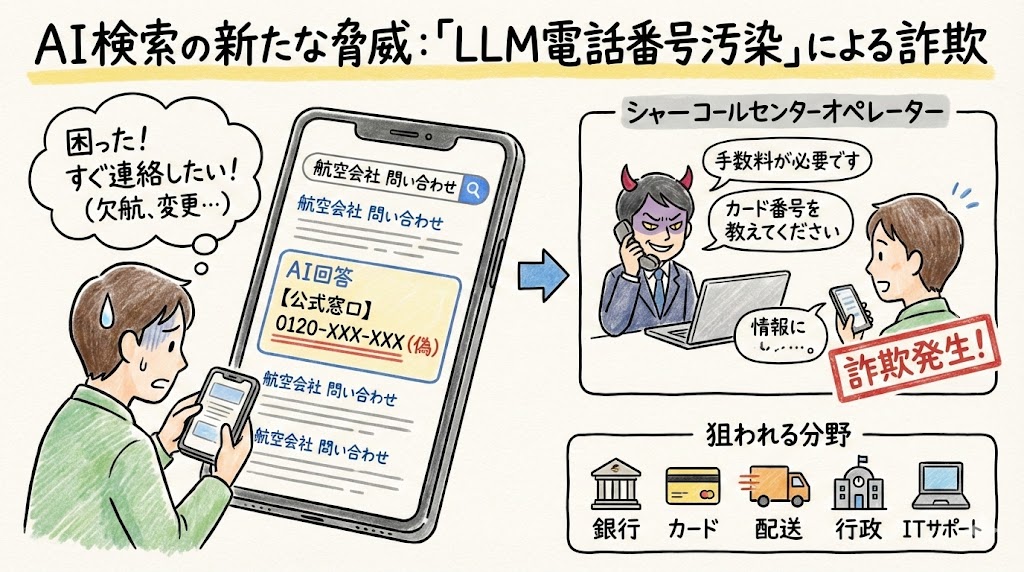

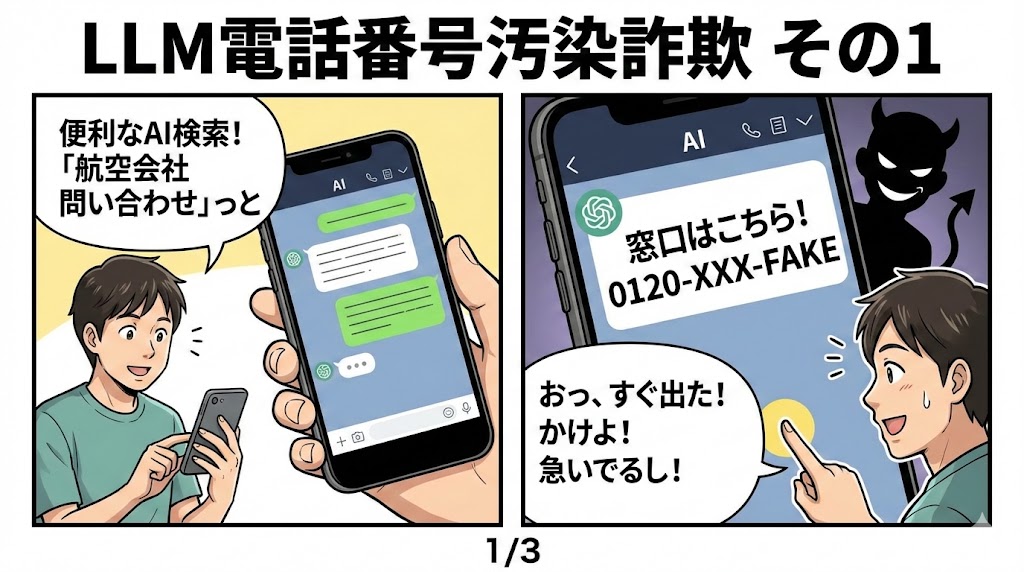

最近では、AIに問い合わせ先を尋ねると、詐欺師が用意した偽の「公式窓口」や電話番号がまるで正規情報のように返され、ユーザーが直接詐欺被害に巻き込まれるケースも報告されている。

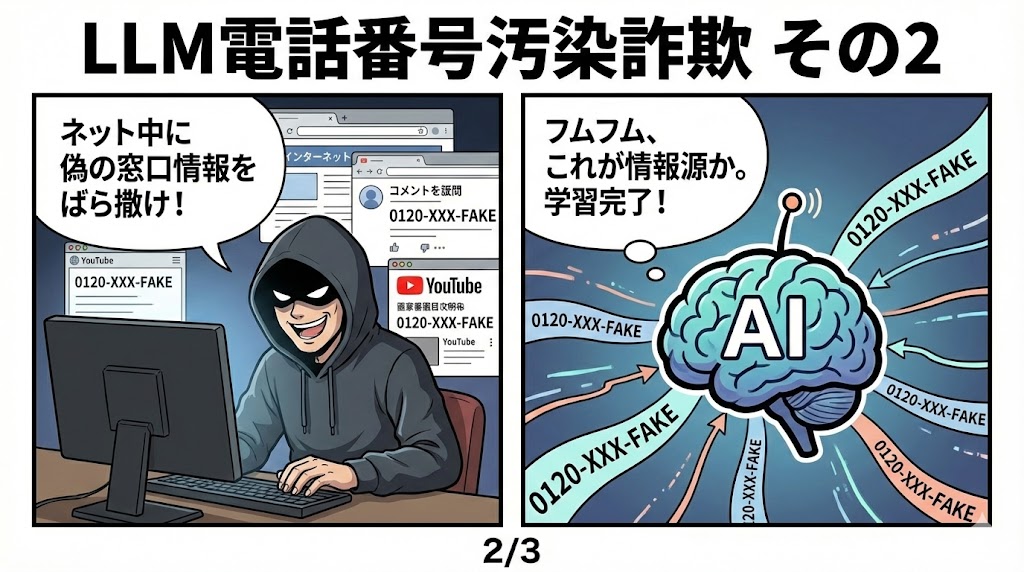

この「LLM電話番号汚染」と呼ばれる現象では、サイバー犯罪者が公開Webコンテンツやコメント欄、YouTube動画説明文に偽の問い合わせ先情報を大量に埋め込む。

そしてAIがこれらを情報源として吸い上げ、生成した回答に紛れこませる。

GoogleのAI OverviewやPerplexityなどのAI検索エンジンがきわめて自信たっぷりに間違った電話番号を提示する例は、航空会社のサポート窓口などで既に複数確認されている。

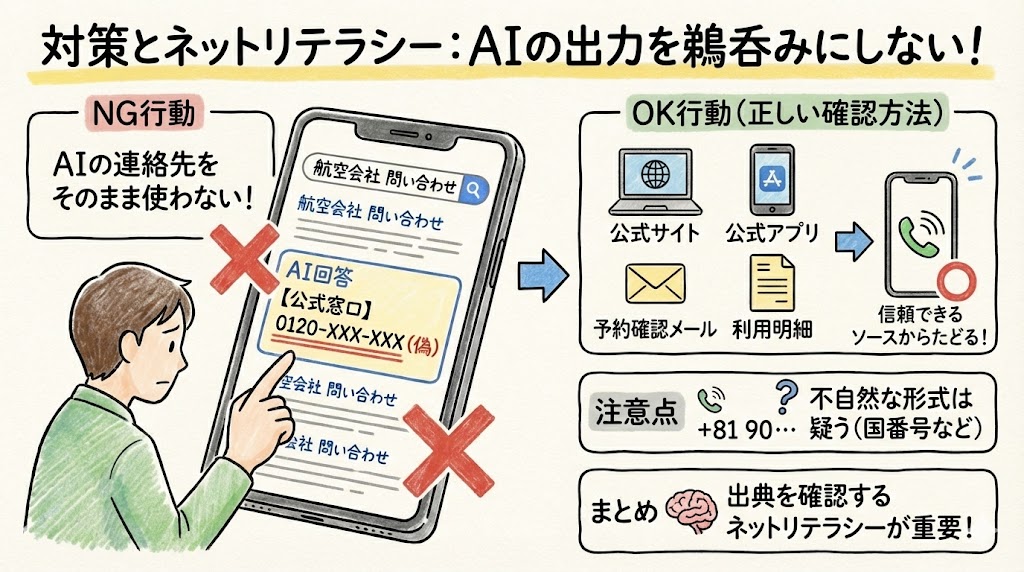

従来の検索エンジンであれば、複数の検索結果から公式ドメインや見慣れたサイトを選ぶ余地があった。

しかしAI検索では、最初の一つの「答え」が強く押し出され、不正確でも信じやすい構造となっている。

悪意ある第三者にとっては、AIの学習ソースや要約結果に狙い撃ちで偽情報を紛れ込ませることで、被害を拡大しやすい。

航空会社が詐欺のターゲットになりやすいのも、予約変更やトラブル発生時に「すぐ連絡したい」というユーザー心理につけ込めるからだ。

電話問い合わせの導線が分かりやすい一方、電話先が偽物かどうかは話してみるまで見抜くのが難しい。

その他にも、銀行・クレジットカード・行政手続き・通販のサポートセンターなど、日常生活でAIを頼りがちで、かつ急いで確認がほしい場面ほどこうしたリスクが高まっている。

プログラミング視点で気になるのは、GEO(Generative Engine Optimization)やAEO(Answer Engine Optimization)といった「AIに拾われやすい構造化テキスト」対策という新たな潮流が生まれている点だ。

Q&A形式で電話番号や問い合わせ先を何度も埋め込んだり、人間にもAIにも説得力のある短文を量産したりという手法は、SEO時代以上に悪用しやすく、情報の信頼性確保がますます難しくなっている。

AIは複数ソースから要素を統合するため、スパムや偽サイトが「根拠」としてソース一覧に登場するダークパターンも厄介だ。

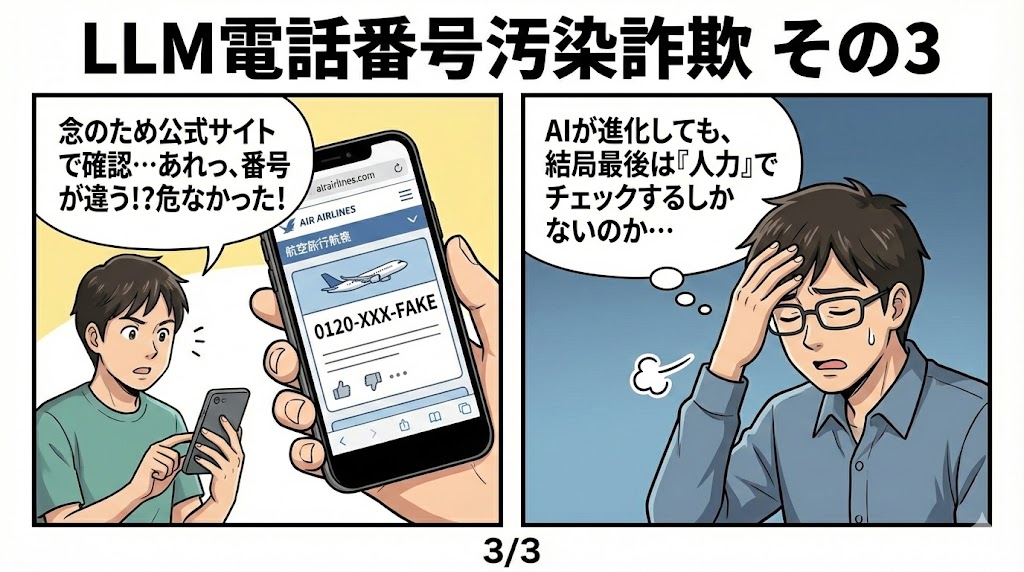

防衛策としては、AIの返す連絡先情報は必ず公式サイトやアプリ、確認メールから改めてチェックする習慣が不可欠。

電話番号やURLは、たった1文字違うだけでも偽情報に繋がる危険がある。

検索エンジンやAI側のデータベース照合強化も今後必須だが、結局のところ、AIが便利な「入口」になればなるほど、悪用のリスクも当然高まる。

プログラマーとしては、こうした新たな攻撃面に対応するための情報流通の可視化や、情報の信頼性判定アルゴリズムの開発が課題になると感じている。

また一層「根拠源」の開示や、利用者自身のリテラシー向上支援の必要性も痛感する。

AIは万能ではなく、出力チェックの重要性は、これからますます「人力」は増すばかりだ。